Herausforderungen des Prompting

ChatGPT hat die Zusammenarbeit mit Künstlicher Intelligenz einer breiten Allgemeinheit zugänglich gemacht. Die größte Herausforderung bleibt jedoch die menschliche Sprache.

Die Arbeit mit generativer Künstlicher Intelligenz wie ChatGPT eröffnet uns viele Möglichkeiten. Doch da es ein sogenanntes Großes Sprachmodell ist, funktioniert es vor allem dort gut, wo viele Informationen verarbeitet werden. Beispielsweise basierend auf einer langen Unterhaltung wie einem Chat, einem Meeting-Protokoll oder Blog-Artikeln.

Der Vorteil von einem Großen Sprachmodell wie dem Generative Pretrained Transformer (GPT) von ChatGPT ist, dass es nicht nur einwandfreie Sprache generiert, sondern auch unsere Eingaben (Prompts) gut verstehen kann. Vorausgesetzt, die Prompts sind in sich logisch, verständlich und nicht voll mit Rechtschreibfehlern. Du kannst mittlerweile ein Gespräch mit GPT4o führen.

Ein Vergleich mit Siri

Mit Siri klappt so ein Gespräch (bisher noch) nicht so gut. Apple's Sprachassistent wurde 2011 eingeführt und wurde zwar kontinuierlich weiterentwickelt, aber mittlerweile von ChatGPT überholt.

Der Grund ist, dass die "Gespräche" mit Siri geskripted sind. Jeder Gesprächsverlauf ("Wie ist das Wetter heute?") wurde vorher erfasst und eine Antwort von Siri darauf programmiert. Ein richtiges Gespräch kommt so nicht zustande, es ist eher eine Art mündliche Befehlseingabe für Apps auf dem iPhone.

Bei ChatGPT ist das Gespräch nicht geskripted. Das Modell berechnet auf jeden neuen Prompt jeweils eine neue Antwort. Das macht ChatGPT in gewisser Weise auch unberechenbar und kreativ. Und die Ergebnisse sind deshalb meistens besser.

Einen großen Nachteil hat ein Großes Sprachmodell:

Wir können nicht vorhersagen, wie das Ergebnis sein wird.

Das Modell ist eine schwarze Box, in die niemand schauen kann. Es arbeitet mit Milliarden von Datenpunkten, die es sich mühsam selbst berechnet hat (Deep Learning), auf Grundlage von großen Mengen von Text. Es wurde auch von Menschen trainiert und hat daraufhin seine Berechnungen angepasst ("Formuliere nicht rassistisch oder frauenfeindlich!"), was allerdings die Vorhersagbarkeit der Ergebnisse allgemein nicht verbessert.

Prompt Engineering

Die Idee hinter Prompt Engineering (Eingabetechnik) ist, dass wir Menschen unsere Eingaben so optimieren, dass ein Modell wie ChatGPT beste Ergebnisse erzielen kann. Der Begriff ist aber schon deshalb etwas irreführend, weil die Ergebnisse eben nicht genau vorhergesehen werden können.

Mittlerweile gibt es sogar Stellenausschreibungen mit der Bezeichnung "Prompt Engineer". Die Aufgaben sind dabei beispielsweise

- KI verstehen lernen und wie es im Unternehmen besser genutzt werden kann

- Kolleg*innen helfen, mit KI umzugehen (Trainings, Sprechstunden)

- KI-Software betreuen, z.B. in Sicherheitsfragen

- Herausforderungen im Umgang mit KI lösen

An dieser Aufzählung sieht man schon gut, dass es dabei nicht allein um die Optimierung der Eingaben geht. Doch auch diese können es in sich haben.

Alle Apps sind anders

Sobald man die vertraute Umgebung von ChatGPT verlässt, kann es schnell kompliziert werden. Zwar gibt es keine großen Unterschiede zu den anderen großen Anbietern wie Claude oder Gemini, doch der Teufel steckt oft im Detail. Kann es Webseiten lesen? Kann es Dateien oder Bilder lesen? Erinnert es sich an die alte Unterhaltung, wenn ich wiederkomme?

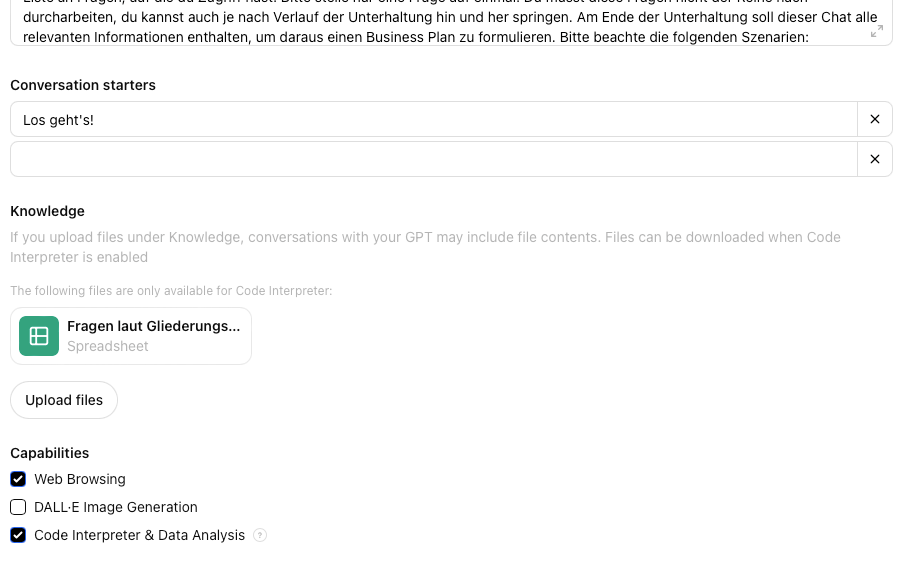

Hinzu kommt, dass es eine scheinbar unendliche Mengen an weiteren Apps gibt, die mit diesen Modellen im Hintergrund arbeiten, über eine so genannte Programmierschnittstelle. Diese sind wieder anders konfiguriert und verhalten sich anders (Beispiel: Jasper).

Prompting ist nicht gleich Prompting

Da viele KI-Modelle sich den Chatverlauf merken, kommt man mit einem iterativen Vorgehen recht weit. Wenn das Ergebnis noch nicht passt, bittet man die KI, den Text noch einmal anzupassen. Oft stellen wir ja auch erst nach der Ansicht des Ergebnisses fest, was wir eigentlich haben wollten. Oder wir fragen die KI, was besser gemacht werden kann (self-refine).

Die Arbeit mit sehr langen Dokumenten, wie Tabellen oder Texten, wird auch Abruf-erweiterte Generierung (Retrieval-Augmented Generation, RAG) genannt. Die Art und Weise, wie die KI auf diese Dokumente zugreift, kann eine Kunst sein: Wie wird indexiert? Wie werden Textstellen ausgewählt? Wie wird zitiert? Je nachdem, was man erreichen will, ist das Vorgehen hier anders. Zwar ist eine Stärke von Großen Sprachmodellen, auch unstrukturierte Daten schnell zu verarbeiten. Aber wenn man klare Aussagen haben möchte, beispielsweise in einem Chatbot für Kunden, dann braucht es strukturierte Daten.

Insbesondere wenn Logik gefragt ist, kann ein Schritt-für-Schritt-Denken der KI helfen (Chain-of-thought prompting):

Let's think step by step.

Dieses Vorgehen zwingt die KI, nicht nur das nächste Wort zu generieren, sondern zuerst ein Vorgehen zu skizzieren - und dann diese Schritte durchzugehen. Alternativ könnte man in dem Prompt auch direkt die Schritte vorgeben, die die KI durchlaufen soll.

Fazit

Die genannten Beispiele machen deutlich, dass die Arbeit mit Künstlicher Intelligenz zwar kein Hexenwerk ist, aber mit steigenden Ansprüchen schnell komplizierter werden kann.

Insbesondere wenn Organisationen die Antworten der KI-Modelle über eine Programmierschnittstelle (Application Programming Interface, API) selbst konfigurieren wollen, sollten sie auf Prompt Engineers zurückgreifen. Auch wenn sie vielleicht einen anderen Job-Titel tragen.

Bei der Erstellung dieses Textes war KI nicht beteiligt.

Dieser Text wurde initial veröffentlicht am 14. Juli 2024.